共计 1529 个字符,预计需要花费 4 分钟才能阅读完成。

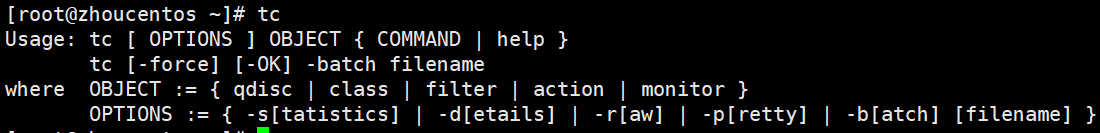

Linux 中使用 tc 进行流量管理。具体命令的使用参考 tc 的 man 手册,这里简单记录一下使用 tc 模拟延时和丢包的命令。

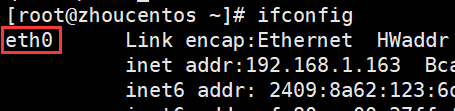

tc流量流控只能控制发包动作,不能控制收包动作,同时,它直接对物理接口生效,如果控制了物理的eth0,那么逻辑网卡(比如eth0:1)也会受到影响,反之,如果您在逻辑网卡上做控制,该控制可能是无效的。(注:虚拟机中的多个网卡可以在虚拟机中视为多个物理网卡)

Linux 中模拟延时和丢包的实现

使用ifconfig命令查看网卡

tc命令:

1、模拟延迟传输

tc qdisc add dev eth0 root netem delay 100ms

该命令将 eth0 网卡的传输设置为延迟100毫秒发送。

更真实的情况下,延迟值不会这么精确,会有一定的波动,我们可以用下面的情况来模拟出带有波动性的延迟值:

tc qdisc add dev eth0 root netem delay 100ms 10ms

该命令将 eth0 网卡的传输设置为延迟 100ms ± 10ms (90 ~ 110 ms 之间的任意值)发送。

还可以更进一步加强这种波动的随机性:

tc qdisc add dev eth0 root netem delay 100ms 10ms 30%

该命令将 eth0 网卡的传输设置为 100ms ,同时,大约有 30% 的包会延迟 ± 10ms 发送。

2、模拟网络丢包:

tc qdisc add dev eth0 root netem loss 1%

该命令将 eth0 网卡的传输设置为随机丢掉 1% 的数据包。

也可以设置丢包的成功率:

tc qdisc add dev eth0 root netem loss 1% 30%

该命令将 eth0 网卡的传输设置为随机丢掉 1% 的数据包,成功率为 30% 。

3、模拟包重复:

tc qdisc add dev eth0 root netem duplicate 1%

该命令将 eth0 网卡的传输设置为随机产生 1% 的重复数据包 。

4、模拟数据包损坏:

tc qdisc add dev eth0 root netem corrupt 0.2%

该命令将 eth0 网卡的传输设置为随机产生 0.2% 的损坏的数据包 。 (内核版本需在2.6.16以上)

5、模拟数据包乱序:

tc qdisc change dev eth0 root netem delay 10ms reorder 25% 50%

该命令将 eth0 网卡的传输设置为:有 25% 的数据包(50%相关)会被立即发送,其他的延迟 10 秒。

新版本中,如下命令也会在一定程度上打乱发包的次序:

tc qdisc add dev eth0 root netem delay 100ms 10ms

例如:

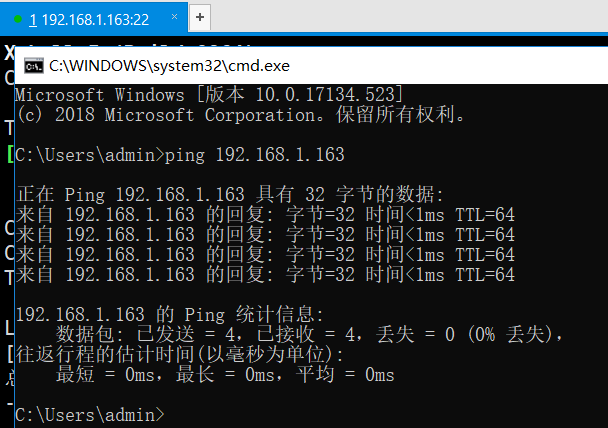

ping出来的最小单位为1毫秒,在执行压测之前,最好用压力机ping一下服务器,如果延迟很高,就没必要测了,因为请求还没发出去都已经有一段时间的消耗了

1. 延时

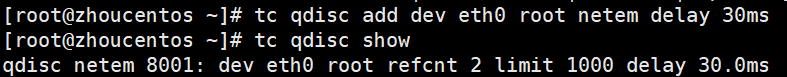

(1)设置延时:给 eth0 设备发包时添加 30ms 的延时(从网卡)。tc qdisc add dev eth0 root netem delay 30ms

(2)显示延时的设置:tc qdisc show

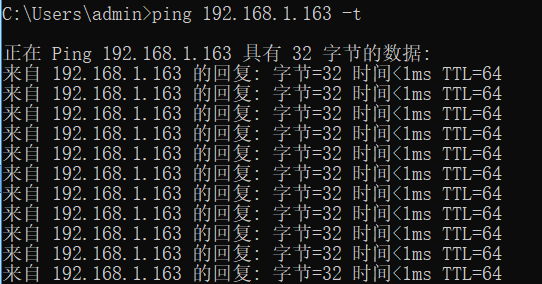

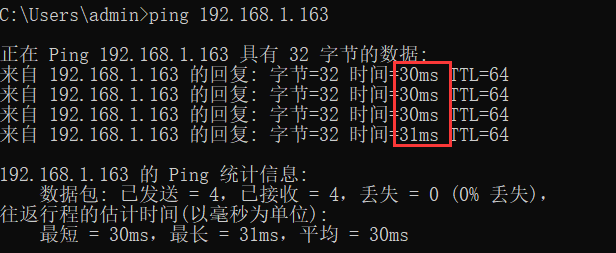

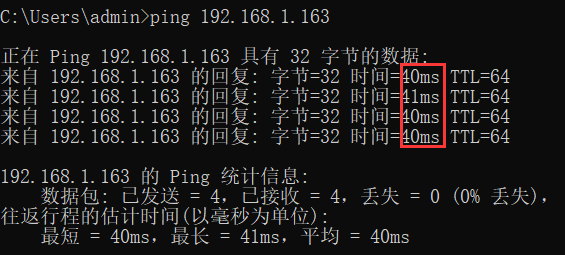

ping一下,看结果

(3) 修改延时:tc qdisc change dev eth0 root netem delay 40ms

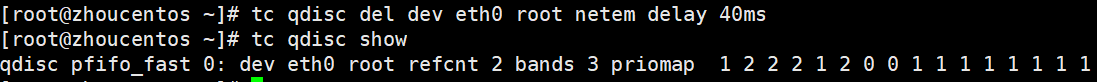

(4) 删除延时的配置:tc qdisc del dev eth0 root netem delay 40ms

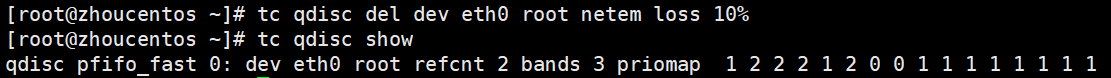

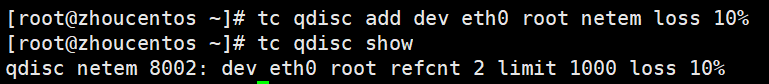

2. 丢包

设置丢包命令如下:tc qdisc add dev eth0 root netem loss 10%(丢10%的包,这里可以按实际情况设置)

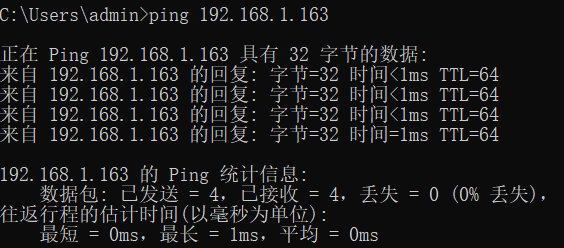

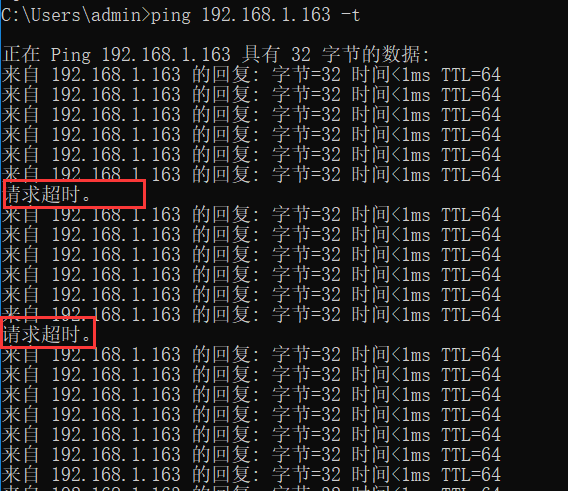

ping一下,每过一段时间就会有一次请求超时,出现概率就是上面设置的概率

如果是通过 SSH 登录设备进行配置丢包的话,配置完这条命令就会感觉到机器访问时有点一卡一卡的。这说明,设备已经开始丢包了,可以通过具体抓包查看。

其他诸如修改、查看、删除的命令,都可以参考上面延时的设置。

不用了一定要删除设置,要不然会一直存在